Robots.txt

Atenție! Nu adăuga/șterge o regulă dacă nu știi precis semnificația ei. Recomandăm să se insereze/șteargă strict regulile solicitate de agenția dvs. de marketing. O directivă greșită poate duce la deindexarea totală a site-ului.

-

Ce este Robots.txt?

Robots este un fișier în format .txt inserat în rădăcina domeniului web. Acesta conține un set de directive adresate motoarelor de căutare. Pentru a putea fi vizualizat în frontend, trebuie să introduceți în browser /robots.txt după numele domeniului dvs. (ex: www.nume-domeniu.ro/robots.txt)

-

De ce este important Robots.txt?

Un website este “scanat” permanent de spiderii motoarelor de căutare (Ex: GoogleBot). Rolul acestei operațiuni este de a verifica și indexa conținutul existent pe fiecare pagină. Trebuie reținut faptul că motoarele de căutare fac această scanare în mod obișnuit, nu trebuie făcute anumite setări în acest sens. Tot ceea ce se poate seta este modul în care spiderii scanează un website. Aceste setări se realizează în fișierul Robots.txt.

Robots.txt are rolul de a transmite motoarelor căutare modul în care spiderii trebuie să acceseze un website. De reținut este faptul că aceștia au un Crawl Budget limitat. Aceasta înseamnă că există o limită zilnică a numărului de pagini accesate de spideri. Tocmai de aceea este extrem de important să se stabilească care sunt paginile bune de accesat și care nu.

Pentru a optimiza acest Crawl Budget, unele pagini sunt automat blocate automat prin meta tag-ul de robots. De exemplu paginile cu filtre multiple. Prin robots.txt trebuie sa blocati alte tipuri de pagini.

Prin intermediul regulilor inserate în acest fișier se poate bloca accesul spiderilor pe paginile mai puțin importante ale website-ului. De ex: paginile /contul-meu și /index.php nu sunt relevante dpv al optimizării SEO și nu e recomandat să fie indexate. Pentru această în fișierul robots.txt se introduce o regulă de Disallow pentru ele. În acest mod se evită indexarea unor pagini mai puțin importante și se redirecționează Crawl Budget-ul spre paginile importante ale website-ului.

-

Cum se editează fișierul Robots.txt?

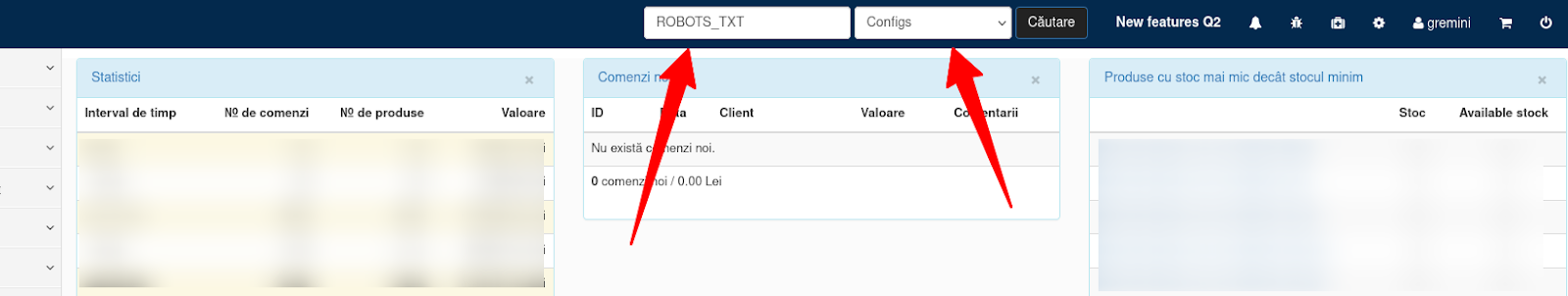

Pentru a edita fișierul Robots.txt din Dashboard caută “Robots_TXT” în Configs.

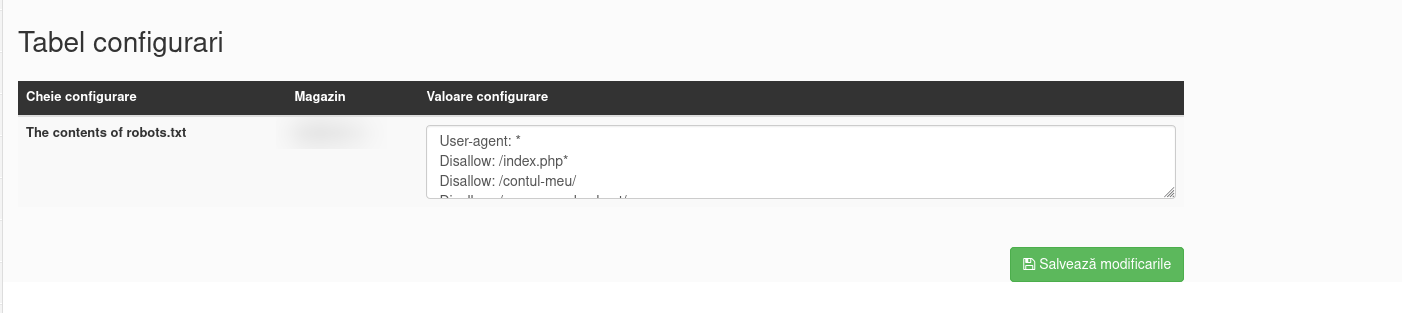

Pe pagina nou deschisă se va afișa secțiunea de edit a fișierului Robots.txt la The contents of robots.txt

Tot ce trebuie să faci este să ștergi/adaugi regulile de Disallow necesare și click “Salvează modificările”. De asemenea în acest fișier poți adăuga adresa URL a website-ului tău, dar nu după directiva de Disallow. (Ex: sitemap: https://www.nume-domeniu.ro/sitemap.xml)

Atenție! Nu adăuga/șterge o regulă dacă nu știi precis semnificația ei. Recomandăm să se insereze/șteargă strict regulile solicitate de agenția dvs. de marketing. O directivă greșită poate duce la deindexarea totală a site-ului.

De ex. recent agențiile de marketing au solicitat magazinelor să adauge în Robots.txt câteva reguli pentru a împiedica spiderii să indexeze link-urile care conțin următoarele UTM-urile 2Performant: *2pau. *2ptt, *2ptu, *2prp și *2pdlst. Aceste reguli se adaugă în fișier sub următoarea formă:

Disallow: /*2pau

Disallow: /*2ptt

Disallow: /*2ptu

Disallow: /*2prp

Disallow: /*2pdlst